NCは約10年間、着実にAI技術に投資し、すべてのAI分野で優れた研究実績を上げています。 現在では、ゲームを含むいくつかのクリエイティブな産業領域と組み合わせて、多くのシナジー効果を生み出すことができるレベルに成長しています。

先立って「TECH Standard」はゲーム業界をリードする革新的な技術力にスポットを当てました。 今回では、技術力を超えて新しい価値を生み出していくNCの未来についてお話します。 デジタルヒューマンとAI技術の方向性、そのビジョンに対する考えが込められています。

2023.04.21 Press Release

NCは約10年間、着実にAI技術に投資し、すべてのAI分野で優れた研究実績を上げています。 現在では、ゲームを含むいくつかのクリエイティブな産業領域と組み合わせて、多くのシナジー効果を生み出すことができるレベルに成長しています。

先立って「TECH Standard」はゲーム業界をリードする革新的な技術力にスポットを当てました。 今回では、技術力を超えて新しい価値を生み出していくNCの未来についてお話します。 デジタルヒューマンとAI技術の方向性、そのビジョンに対する考えが込められています。

もし将来が明確に決まっているのであれば、R&D組織は必要ないかもしれません。 しかし、現実にはいつも予期せぬことが起こるものです。 そのため、あらかじめ未来を探検して進むべき道を決定する組織が必要です。 NCではR&D組織がその役割を果たします。 現在から未来を探検して不確実な世界を模索しています。

10年前から歴史を受け継いできたNC R&Dセンターは、多くの結果をゲームに適用してきました。 例えば〈リネージュW〉はMMORPGジャンルで世界初の「グローバルワンビルド」としてサービスしています。 ここにはAI翻訳技術が非常に重要な役割を果たしました。 ゲームチャットウィンドウを自動翻訳する機能で、グローバルプレーヤー間の言語障壁をなくし、真の「連続性」を確保しました。 このようにR&D、「探検」に着実に投資したため、NCは従来のゲームでは見られなかった新しい基準を提示し続けることができました。

NCの次の目標はリアルタイムで相互作用し、人間の創意力と楽しさの価値を発展させる「デジタルヒューマン」です。 すでに研究組織を立ち上げAI、NLPなどデジタルヒューマン開発に必要なすべての技術要素を備え、未来に向かって進み始める準備を終えました。

毎年3月にサンフランシスコで開催されるGDC(Game Development Conference)で、Epic GamesはUnreal Engineを使用したゲームを発表しています。 今年はこの発表会にNCが招待されました。 まだ公開されていませんが、新しく発売されたUnreal Engine5を使用して開発しているゲームがあるため、NCの革新的な技術力を世界中の人々に披露する良い機会でした。

GDCではNCのデジタルヒューマンと今後発売されるゲームである<プロジェクトM>を公開しました。技術とゲームをどのように効果的に披露するか悩んだ末、『デジタルTJ』が〈プロジェクトM〉のゲームの中に入るシナリオを企画しました。

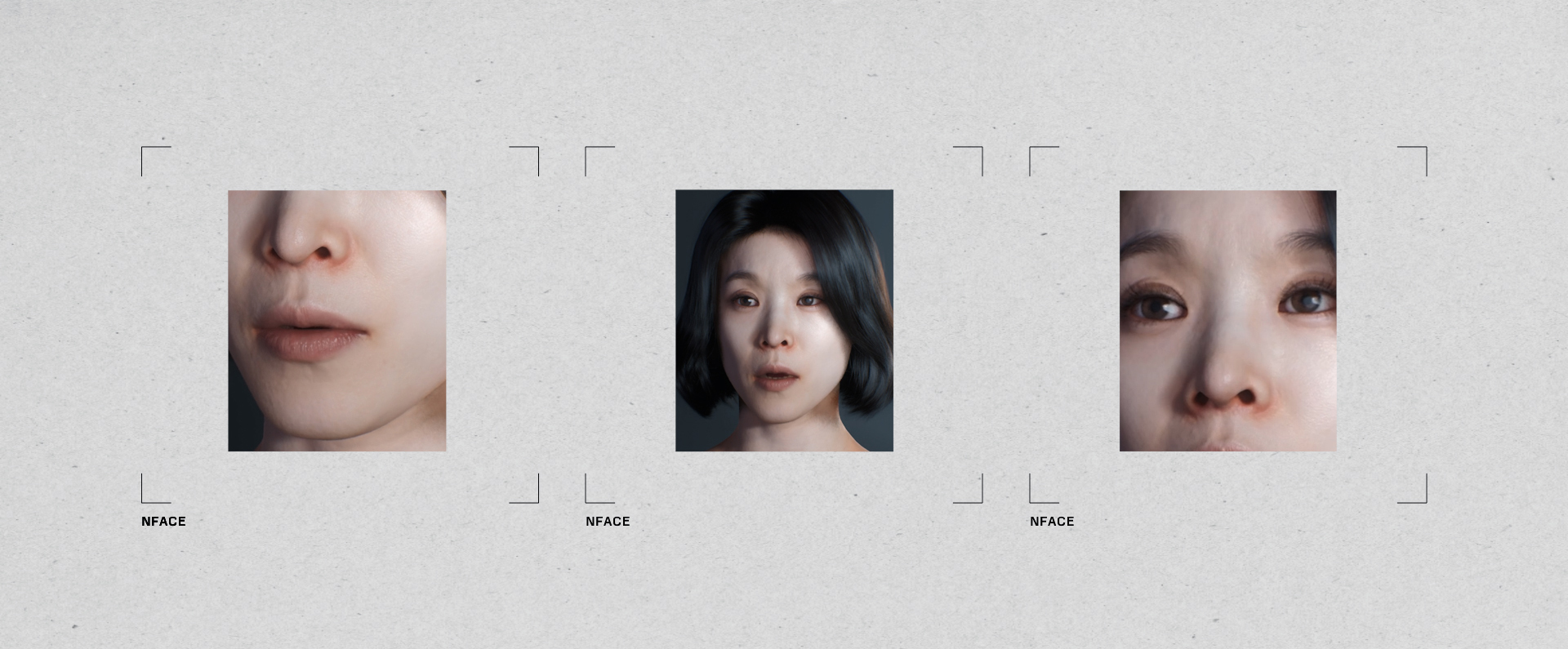

今回の『デジタルTJ』はリアルに再現する程度から、さらに進化しゲームに合わせて再構成しました。 これを実現するためにNCの3Dスキャン、4Dスキャンなど次世代ハードウェア装備とAIボイス、AI Voice-to-face技術など多様なAI技術を融合させました。

このようにNCが開発している技術を総動員し、顔の表情をリアルに引き出したり、望む通りに変形させたりもしました。 NCの技術力を集約したことにより、これらすべてが可能となりました。

ゲームの中の世界は仮想空間そのものであり、ゲームとデジタルヒューマンは本質的に切っても切れない関係です。 デジタルヒューマンが活動できる領域である仮想空間の世界観をより魅力的に表現する存在は、より具現されたデジタルヒューマンです。

しかし、これまで披露してきたデジタルヒューマン技術は、ユーザーに一方的に情報を注入し伝達する役割に留まっていました。 私がある行動をした際に見せる反応が単純であったので、共感を形成、予想できない反応から来る面白さなどを感じにくかったです。

一人でプレイするより、大勢でMMORPGを一緒にプレイする時のほうが、より面白く感じる理由は、お互いに相互作用が発生するからです。 そのため、デジタルヒューマンとの相互作用はゲームで見逃せない重要な要素です。 人々と疎通するのと似たように、ある行動をした時、デジタルヒューマンが色々な要素を考慮する深い思考過程を経れば反応の結果値は状況によって変わるでしょう。 つまり、楽しさを与えられる存在を作り出すことは、相互作用する対象がどれほどレベルの高い思考ができるかによって決まります。 したがって、これからのデジタルヒューマンは、人同士のコミュニケーションと同じくらい深く相互作用できるようにすることが重要です。

AIセンターを10年以上維持してきたNCは、AIや最新グラフィックス技術、優れたアート人材など、デジタルヒューマンに必要な力量を豊富に備えています。 これを有機的に結合して、より高度化したデジタルヒューマンを作ることだけが残りました。

GDCでNCが公開した『デジタルTJ』は、今後披露する様々な技術の予告編です。 これから披露するデジタルヒューマンの最終目標は、人のように聞いて話して動くのはもちろん、状況に応じて自ら考え、自らの判断によって話し、行動する存在です。 人と相互作用が可能な存在なのです。

デジタルヒューマンを実現するための技術の目標は「実在感(Presence)」、そして没入感(Immersive Experience)を与えることができる「インタラクション」です。 実在感は現実に実在する人が動くようなビジュアルを伝えることです。 インタラクションは自然な表情、動作および些細な身振りと生体反応まで「人のように」作ることで、「本当の人と対話している」ように没入感を高める技術です。

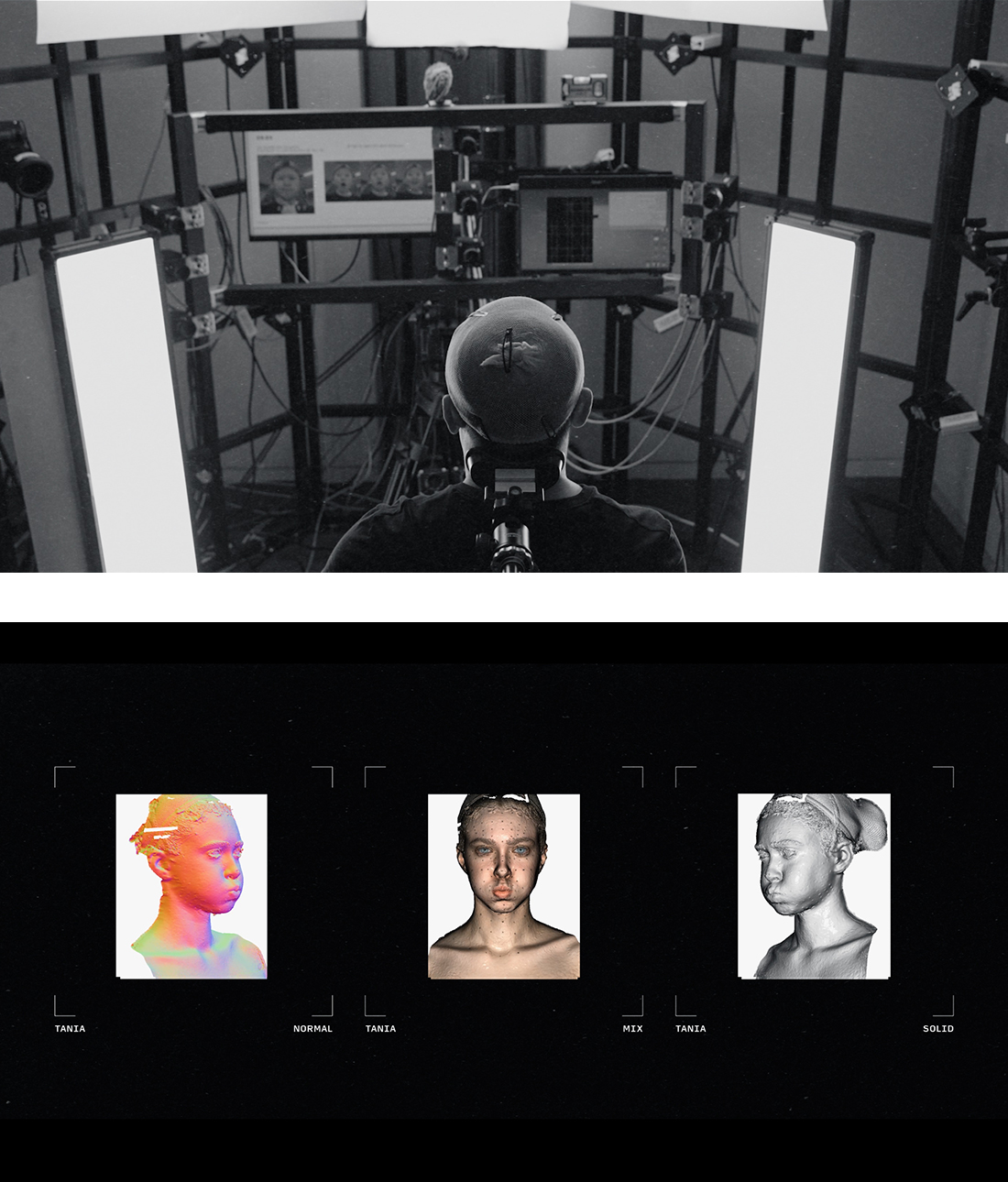

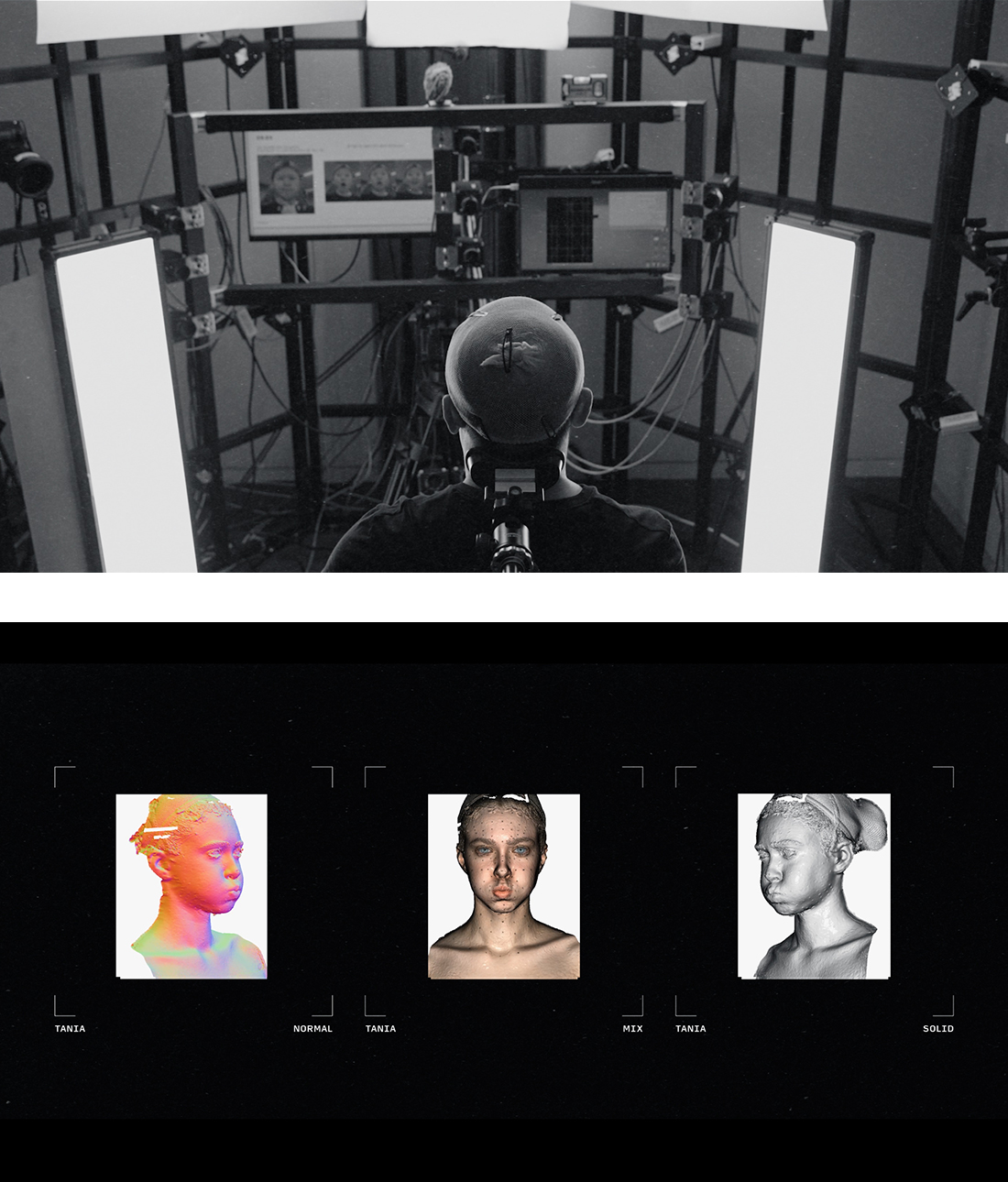

これには、優れたスキャニング技術が不可欠です。 NCは4Dスキャナーを自主的に製作し、積極的に活用する準備を終えました。 3Dスキャンの次世代技術である4Dスキャンは、顔の3D情報をイメージだけで抽出することができた以前の技術を、さらに進化させ動画でスキャンする技術です。

4Dスキャン技術は3Dスキャンのようにイメージ情報を活用しますが、連続撮影で顔のしわ、小さな筋肉の微細な動きまでもキャプチャーできます。 連続的に撮影する間、すべてのカメラの許容誤差は1ミリ秒(1/1,000秒)以内で、照明も均一に光量を調節しなければなりません。 このように複雑な過程を経て抽出したデータでより自然な表情、動作を得ることができます。

前述したように没入感を高めるのは「インタラクション」です。 デジタルヒューマンがインタラクションをうまくするためには、大きく分けて複合認知技術(Multimodal Recognition AI)、チャットボット技術(Conversational AI)、アクティング技術(Visual Acting AI)の3つが重要です。

複合認知技術は対話する相手の状態、感情など様々な要素を感知して分析する技術であり、チャットボット技術は相手の言葉を分析して適切な回答を生成する技術です。 アクティング技術はこれらを効果的に表現する技術で、音声合成やグラフィックス技術などが含まれます。 これを通じて相手の話だけでなくコンディションまで把握して総合的に適切に答え、その過程で表情や些細な身振りなど非言語的コミュニケーションまで表現することができる。

NCは、このようなデジタルヒューマンを一回限りのものにするだけでなく、高度化したデジタルヒューマンをより簡単かつ迅速に大量生産できるようパイプラインの形成にまで進みたいと考えています。 究極的にはデジタルヒューマンがすべての分野で活躍するIPとして一般ユーザーも大衆的に活用できるほど効率的な技術として定着するようにし、その過程で作られた技術などリソースも多様に事業に活用しようと思います。

このため、NCは時間と費用が多くかかる複雑な過程を複数のAI技術で自動化、効率化することに焦点を合わせています。 特に「リアルタイムインタラクション」が可能なデジタルヒューマン生成パイプラインは2つに分けられました。 一つは主に映画やゲームに使われる高品質デジタルヒューマンを作るためのAI基盤のグラフィックスパイプラインです。 このパイプラインを通じてデジタルヒューマンがゲーム、映画、ドラマ、エンターテインメント、現実世界のサービスなどあらゆる分野で活躍できるようにする計画です。 もう一つはデジタルヒューマンの品質を一定に維持しながらも大量生産するVisionAI基盤のパイプラインで、AI技術を基盤に費用と時間を効率化することに重点を置いています。 一般ユーザーも簡単に自分だけのデジタルヒューマンを保有できる技術を目指しています。

さまざまな目的のパイプラインを作成していますが、共通の目標はデジタルヒューマンを以前よりも効率的に生産することです。 このような観点から、以下のように核心的な技術を選ぶことができます。

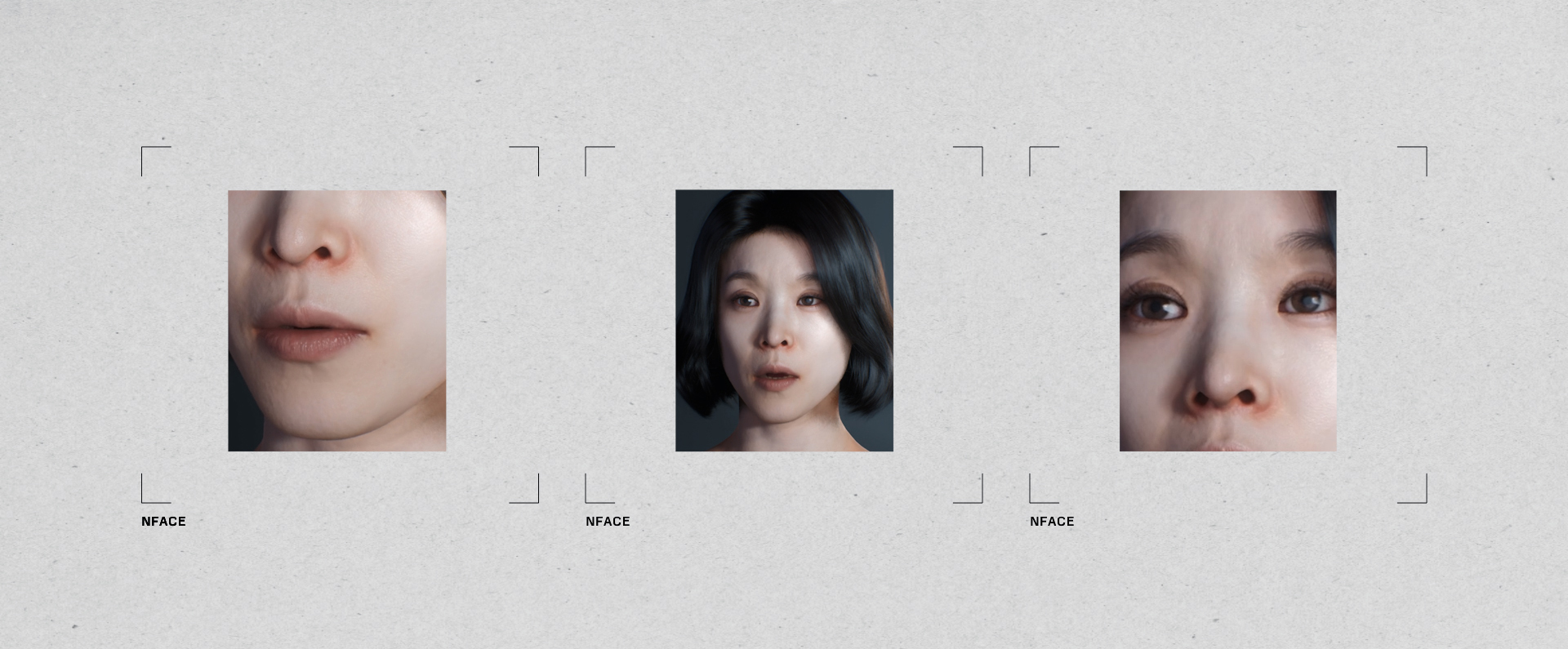

NCで開発したVoice-to-Face技術NFaceは、セリフや声を入れると状況に合った表情や唇の動きなどを自動的に生成するAI技術です。 音声とキーポーズさえあれば、AIがモーションキャプチャーレベルの高品質Lip Syncアニメーションを少ない費用で生成してくれます。 追加的に視線、首の動き、瞬きなどのモーションも生成でき、簡単な感情状態まで顔に反映したアニメーションも作ることができます。 NCはこの技術で韓国語に最適化されたLip Syncができるよう独自のシステムを構築しました。 今後、ゲームだけでなく映画、アニメーションなどの分野でも活用されます。

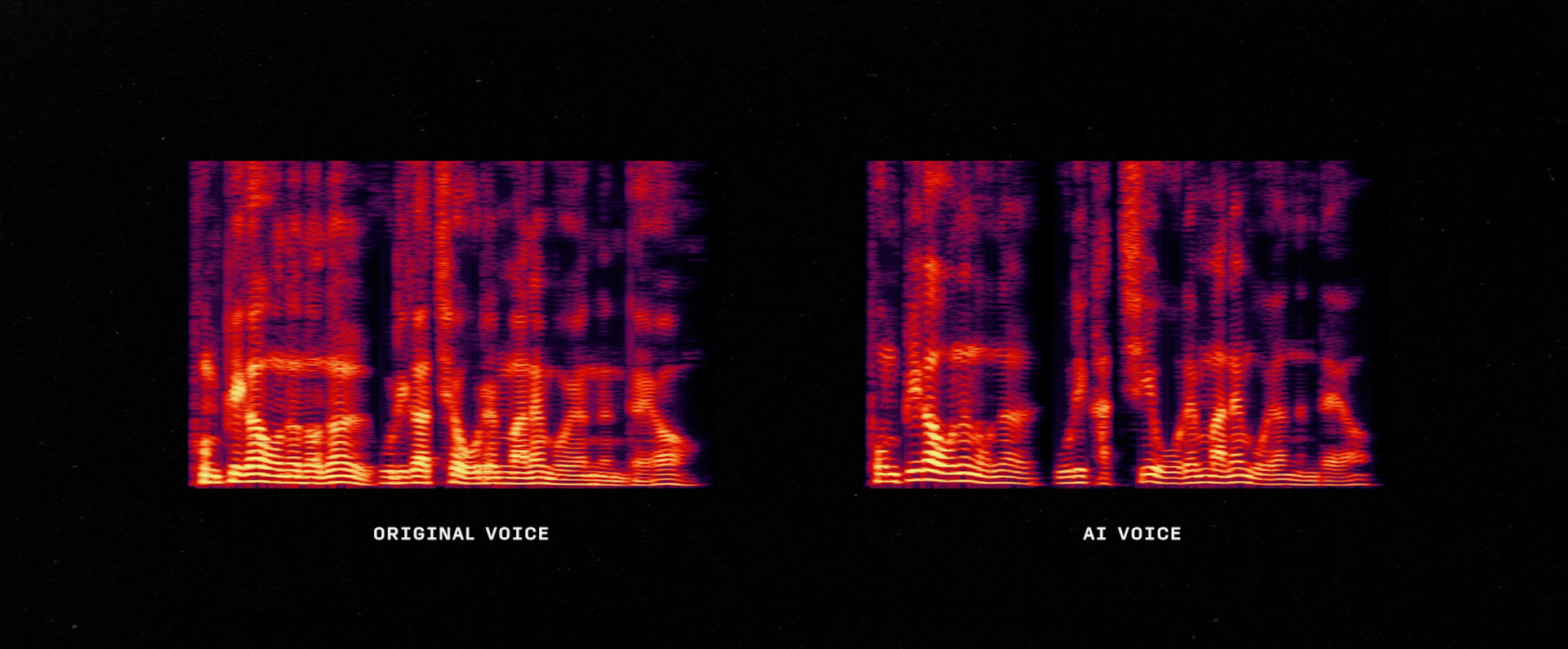

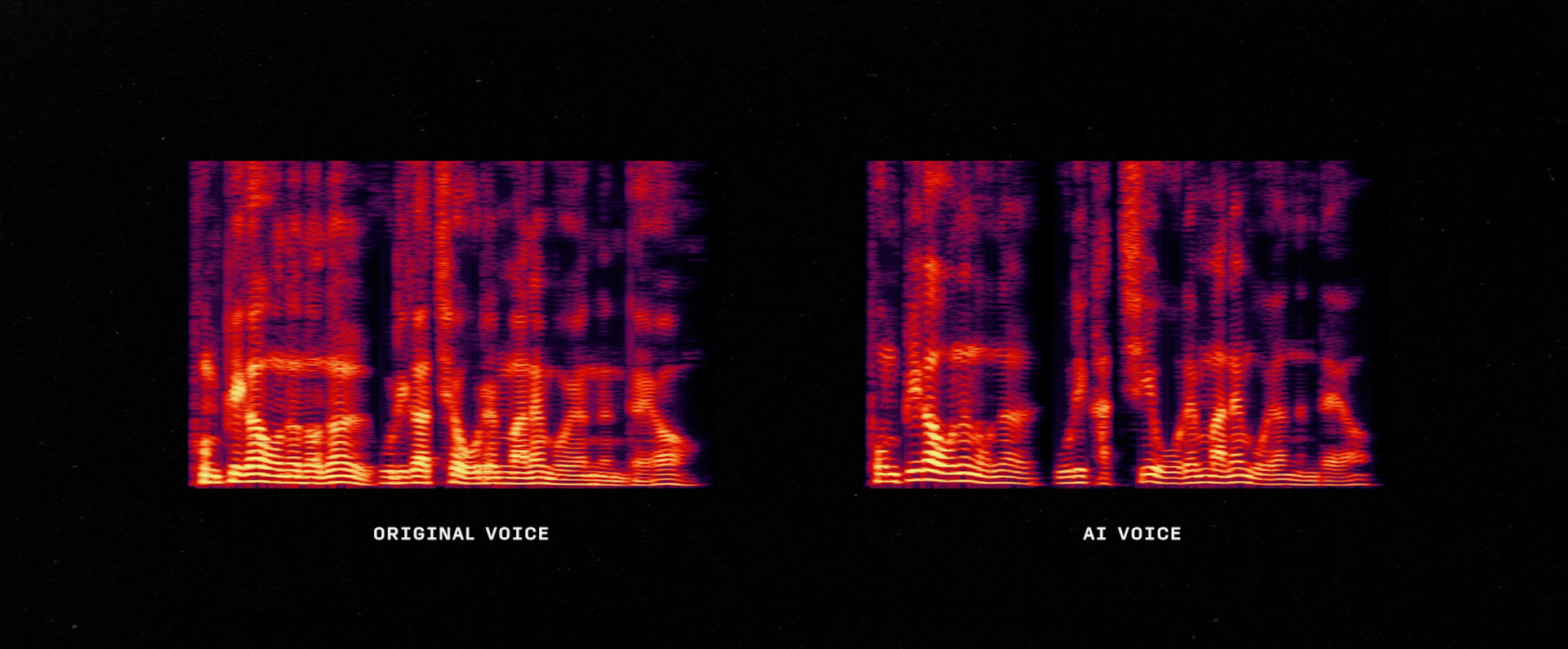

TTS(text-to-speech、テキスト音声変換)は、入力されたテキストをAIが状況に応じた音声で話す技術です。 TTSが文字を話せるようになるには、テキストと音声がペア(pair)になったデータを学習させる過程が必要です。 例えば、「こんにちは」という文字を音声で話すことに関連して、2人の関係を学習する過程です。 この時TTSは録音した人の声の特徴、すなわち話し方、音色、トーン、発話速度も学習します。 このように学習を終えたTTSはデータを録音した人の声、話し方でどんな文字でも読めるようになります。 30分程度の音声データでTTS生成が可能です。 このように作ったTTSはナビゲーション、案内放送、オーディオブック、YouTubeコンテンツにも活用できます。 今後の研究目標はTTSが文字をより自然なイントネーションで正確に発音し、雑音なくきれいな音声を生成するようにすることです。

NCは様々な不確実な状況と多様なテーマについても自然に話し合い、人とインタラクションできるデジタルヒューマンの開発に総力を尽くしています。 特に相互作用が重要なゲームでは、このような技術力が光を放つことができます。 ゲームで出会うすべてのキャラクターが同じ答えだけを繰り返すNPCではなく、私と一緒に楽しむゲームパートナーまたは私の一生に二度とないライバル、再び会うことができない特別な英雄になれるという話です。 このようにデジタルヒューマン技術は、これまで見たことのない新しいゲームジャンルを開拓するのに役立つでしょう。 人々が望むデジタルヒューマンを作るという共通の目標のために、NCは今後も努力と時間を惜しみません。