Embedded EthiCS

for a Better Tomorrow

더 나은 미래를 향한 윤리 교육

인공 지능이 만들어내는 놀라운 변화는 빠르게 일상이 되어갑니다. 첨단 기술로 연결된 유토피아에 대한 상상만큼이나 디스토피아에 대한 우려도 점점 커져가는 시점이죠. 사람들이 기술에 대해 갖는 문제인식이나 정부가 마련하는 규제나 정책의 수준에서 인공 지능의 부정적인 영향력을 막을 수 있을까요. 세계의 석학들은 그 답을 공학과 인문학이 포함된 윤리 교육에서 찾고 있습니다. 우리는 30년, 50년 후를 내다보고 세상의 변화에 공헌할 수 있는 교육에 대해 새로운 관점으로 고민해야 할 때입니다.

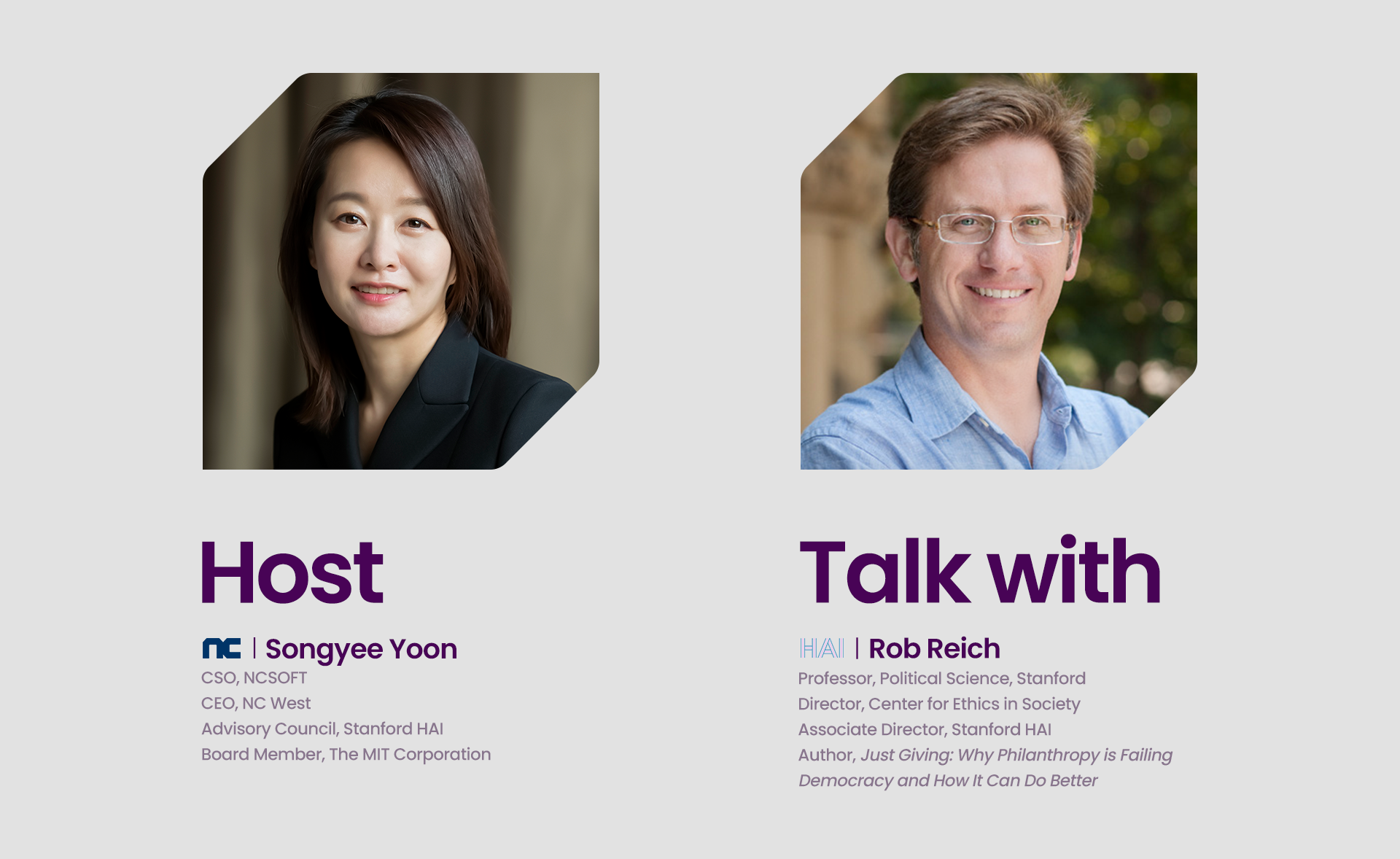

[AI FRAMEWORK]는 인공지능과 인류의 미래를 고민하는 세계적인 석학들의 시선을 통해 ‘AI를 바라보는 새로운 관점’을 제시하는 엔씨의 새로운 콘텐츠 시리즈입니다. 엔씨의 AI Center 설립을 주도하며 첨단기술의 윤리적 문제를 탐구해 온 윤송이 CSO가 공학, 정치학, 철학 등 각 분야의 리더들을 만나 서로의 생각과 관점을 나눕니다.

이번 편에서는 AI의 영향력을 빠르게 인지하고, 선도적으로 공학과 윤리학의 융합 수업을 진행하는 대학의 사례를 중점적으로 이야기해봅니다. 엔씨는 2020년부터 MIT와 스탠포드대학교가 이끄는 AI 윤리 커리큘럼 개발을 후원하며, 이를 일반 대중에게 오픈소스로 배포할 수 있도록 했습니다.

스탠퍼드 인간중심 AI 연구소(HAI – Stanford Institute for Human-Centered Artificial Intelligence)의 롭 리쉬(Rob Reich) 부소장과 함께 스탠포드 대학에서 진행하는 공학과 윤리학의 융합 수업 ‘Embeded EthiCS’에 대해 대화를 나눠보겠습니다. 더불어 인공 지능이 가져올 위협에 대처하는 방법으로서 윤리 교육은 어떤 의미가 있고 어떻게 수행할 수 있을지, 그리고 이를 통해 인공 지능과 함께할 미래는 어떤 모습일지 ‘현재와 미래를 위한 교육’에 관해 심도 싶은 이야기를 나눠보겠습니다.

AI [Education] Framework

2. Embedded EthiCS for a Better Tomorrow

더 나은 미래를 향한 윤리 교육

Songyee Yoon

엔씨소프트의 사장(최고전략책임, CSO)이자 북미 법인(NC West) 최고 경영자로 엔씨의 글로벌 사업 전략을 총괄하고 있다. 엔씨의 AI Center 설립을 주도해 AI와 NLP에 관한 다양한 연구 개발 성과를 기업 경영에 접목하고 있다. 특히 AI가 미치는 사회적 영향과 AI 윤리를 지속적으로 고민하며, 현재 미국 스탠퍼드 인간 중심 AI 연구소(Human-Centered AI Institute, HAI) 자문 위원과 메사추세츠 공과대학(MIT) 이사회 이사로 활동 중이다.

Rob Reich

정치학 교수이자 스탠퍼드 인간중심 AI 연구소(Human-Centered AI Institute, HAI)의 부소장으로서 스탠퍼드 대학에서 철학 강의를 하며, 교육 대학원에서도 강의를 하고 있다. 스탠퍼드 대학 사회 윤리 센터(Center for Ethics in Society)의 책임자이자 자선 및 시민 사회 센터(Center on Philanthropy and Civil Society)의 공동 책임자이기도 하다. 윤리, 공공 정책 및 기술 분야에 중점적으로 관심을 두고 최근 『디지털 기술과 민주주의 이론』(Digital Technology and Democratic Theory)이란 책을 출간했다. 그외 정치학 책뿐만 아니라 교육에 관한 책도 여러 권 집필했다.

We Have More Options Than We Think

우리가 할 수 있는 행동의 총합에 대하여

윤송이 지난 편에서 인공 지능이 불러올 잠재적인 위협과 피해에 대해 이야기를 나눴습니다. 이에 대처하기 위해서는 누가 교육받는 것이 중요할까요? 역시 소비자를 대상으로 정보를 제공해야 할까요? 아니면 개발자나 정부를 대상으로 정보를 제공하는 것이 중요할까요?

롭 리쉬 글쎄요, 저는 말씀하신 모든 주체들이 중요하다고 생각합니다. 어찌 되었든 그저 소비자에게만 맡기는 방법으로는 문제를 해결할 수 없습니다. 왜냐하면 그런 방식은 일종의 일대일(one-by-one) 접근법이라서, 보다 광범위하고 집단적으로 대처할 수 없기 때문이에요. 가령 어떤 사람은 ‘페이스북’에 싫증이 나서 핸드폰에서 페이스북 앱을 삭제하는 것만이 여러 문제의 유일한 해결책이라고 말합니다. 또는 스마트폰이 온갖 알림과 사용자의 주의를 산만하게 하는 것들로 가득하기 때문에 아예 화면을 흑백으로 만들어 버려야 한다고 하기도 하죠. 그러고는 “이것이 소비자의 힘이다”라고 주장합니다. 하지만 이게 우리가 할 수 있는 행동의 전부라면, 결국에는 우리가 손해를 입게 될 거예요.

기업은 혁신하는 과정에서 책임감을 가져야 하고 다양한 비영리 및 자선 단체와 시민 사회 조직은 여러 가지 상황에 민첩하게 대응해야 합니다. 그리고 우리는 정부의 개입 또한 고려해야 합니다. 제가 생각하는 콘텐츠의 검열 혹은 규제 지침에 관해 한 가지 예를 들어볼게요. 우리가 걱정없이 영화관에 갈 수 있었던 때의 이야기인데요. 미국에서는 모든 영화에 등급이 매겨집니다. G(General Audiences), PG(Parental Guidance Suggested), R(Restricted), 또는 No content, 이런 식으로요. 그런데 이건 미국 정부에서 정한 법이 아니에요. 자체적으로 규제하고, 소비자에게 정보를 제공하기 위한 영화 업계 내에서의 자발적인 협업이죠. 그래서 소비자들은 자녀들의 영화 시청을 허락할지, R 등급일 경우 연령 제한이 있는지 등 정보를 바탕으로 결정을 내릴 수 있어요.

롭 리쉬 저는 소셜미디어 업계에서도 이런 협력 방식을 시도해 볼 만하다고 생각해요. 실제로 페이스북 감독 위원회(the Facebook oversight board)가 그런 시도를 한 바 있지만, 그것은 오직 ‘페이스북’에만 해당하는 것이었어요. 영화 협회(Motion Picture Association)의 사례에서 중요한 점은 대부분의 제작사가 이러한 방식에 참여했고, 그들이 자발적으로 콘텐츠를 제출해서 등급을 받는다는 것입니다. 그것이 바로 소비자의 위에 있지만, 정부보다는 아래에 있는 예지요(That’s an example that sits above the consumer and is below the government). 그러니까 제가 강조하고 싶은 것은 단순히 ‘개인 사용자의 결정이냐’ 아니면 ‘정부의 규제냐’를 선택하도록 내버려두는 것이 아닙니다. 그 사이엔 수많은 선택지가 있으니까요.

윤송이 맞아요, 위의 모든 사례처럼요.

롭 리쉬 네, 맞습니다. 또 한 가지 제가 말씀드리고 싶은 것이 있어요. 제가 현재 대학교에 재직하면서 가장 좋은 것 중 하나는 바로 열아홉, 스물, 스물한 살 정도의 젊은이들을 가르친다는 것입니다. 이들은 10년 안에 리더십과 책임감이 필요한 자리에 앉아있을 거예요. 새로운 프레임워크와 새로운 ‘인간 중심 AI’를 토대로 차세대 리더들을 양성하는 것은 대학만이 이끌어 낼 수 있는 변화이자, 장기적인 목표입니다. 기업이 20년 후의 미래를 생각하면서 인재를 육성하는 것은 정말 어렵습니다. 다음 달의 분기별 수익 보고서를 위해 달성해야 하는 목표가 있기 때문이에요. 하지만 다행히도 스탠퍼드는 분기별 수익 보고서가 없고 공개적으로 거래되는 주식도 없습니다. 그래서 실제로 우리는 ‘앞으로 10년 동안 사람들을 어떻게 교육시켜야 30년 후 세상이 변화될 수 있을 것인가?’하는 것에 대해 생각해 볼 수 있겠죠.

Integrating Ethics Across CS Education

컴퓨터 공학과 윤리학의 융합 수업

윤송이 네, 맞습니다. 교수님께서 캠퍼스에서 진행하시는 윤리 교육 과정에 대해 알아볼 수 있는 훌륭한 전환점이네요. 그 새로운 교육 과정에 대해 말씀해주시겠어요? 현실적으로 윤리학이 어떻게 적용되고 있는지요, 실제 목격한 초기 성공 사례가 있나요?

롭 리쉬 네, 좋아요. 저희는 송이 님 같은 분들의 지원 덕분에 “인간 중심 AI”를 기반으로한 흥미로운 일들을 하고 있습니다. 저는 그중에서도 특히 상호 보완적인 두 가지 활동에 매우 흥미를 갖고 있어요. 첫 번째는 우리가 ‘임베디드 에식스(Embedded EthiCS)’라고 부르는 것입니다. 철학 혹은 윤리학 교육을 받은 사람, 또는 정치학과나 철학과 출신의 사람을 컴퓨터 공학 교수진과 짝을 지어줍니다. 철학 교육을 받아 보지 못한 컴퓨터 공학 교수에게 매우 탄탄한 윤리학 콘텐츠를 수업 내용에 포함시키라고 요구할 게 아니라, 그런 철학 교육을 받은 사람과 협력을 하게 하는 것입니다. 저희는 핵심 강의들의 모듈을 개발하고 있습니다. 스탠퍼드에서 컴퓨터 공학을 전공하는 모든 학생들이 인공 지능과 더 폭넓게 컴퓨터 공학 분야의 윤리적 프레임워크와 질문들에 노출될 수 있도록이요. 즉, 알고리즘 모델의 기초를 배우면서 동시에 알고리즘의 편향성과 공정성에 대한 질문을 직면해야 합니다. ‘당신이 윤리학에 관심이 있다면 철학과에서 수업을 들으세요.’라고 하는 것이 아니라, 컴퓨터 공학과의 주요 수업에 윤리학이 포함될 것입니다. 제 생각에, 올해 말까지 3, 4개 정도의 관련 수업이 개설될 것 같고 내년까지는 6, 7개 수업이 열릴 것으로 예상돼요.

그리고 두번째는 제가 개인적으로 참여하고 있는 대규모 입문 과정인데요. 철학자인 저뿐만 아니라 공공 정책 경험이 있는 사회 과학자와 컴퓨터 공학 교수가 함께 참여합니다. 사실 캠퍼스에서 가장 인기 있는 교수는 지난 10년간 컴퓨터 공학 입문 강의를 가르쳐 왔던 Mehran Sahami 교수예요. 그는 매우 훌륭한 선생님이지요. Mehran Sahami 교수의 컴퓨터 공학 입문 강의는 적어도 스탠퍼드에서는 유일하게 한 과정 내에서 공학 과제, 정책 그리고 철학을 모두 다루는 수업입니다. 그래서 저희는 이 수업을 최대한 많은 학생이 들을 수 있는 강의로 만들고 싶었고 약 300명 정도가 수강할 수 있습니다. 컴퓨터 공학 대학원생은 철학 논문 채점 방법을 모르고, 철학 대학원생은 공학 과제를 어떻게 채점하는지 모르기 때문에 이 수업의 조교들이 고생하지만 저희는 지금 3년째 이 큰 임무를 수행하고 있습니다. 맞춤형 사례 연구 수업도 있고, 기술 분야에서 일하는 사람들을 위한 야간 수업도 진행하고 있고요. 더불어 이 자료를 바탕으로 올해 여름에 나올 책도 썼습니다.

만약 우리가 다른 대학과 함께 대학 내 여러 분야에서도 이와 같은 일을 계속 반복한다면, 교수나 학생 혹은 그 누구나 기술 혁신의 윤리적, 사회적 차원에 직면하는 것을 피할 수 없을 것입니다. 이는 세상을 더 나은 방향으로 이끄는 데 큰 공헌이 될 것이라고 생각합니다.

윤송이 멋지군요. 스탠퍼드가 젊은 학생들에게 이런 교육 과정을 제공하는게 매우 훌륭하다고 생각합니다. 그럼 그 교육 과정과 교육 자료를 저희도 이용할 수 있다는 거죠?

롭 리쉬 네, 모든 자료는 일정한 조건하에 자유로운 이용이 가능하고, 방금 말씀드린 수업의 웹사이트에서 모두 확인할 수 있습니다. (웹사이트 바로가기) 저작권으로 보호되는 자료를 제외하고는 ‘임베디드 에식스(Embedded EthiCS)’에서 개발하고 있는 모듈과 비슷한 모든 사례 연구와 자료를 다운로드 할 수 있습니다. 기업이나 다른 대학에서 자유롭게 활용하길 바랍니다. 이 자료들은 모두를 위한 것이니까요.

How to Put Ethics Into Practice

교육이 실천으로 이어질 수 있을까

윤송이 하지만 결과적으로 우리는 유치원에서 배웠던 모든 것을 반드시 실천하지는 않지요. 그런 수업을 들은 학생들이 자신이 배운 것을 사회 전반에 걸쳐 실천할 것이라고 기대하시나요?

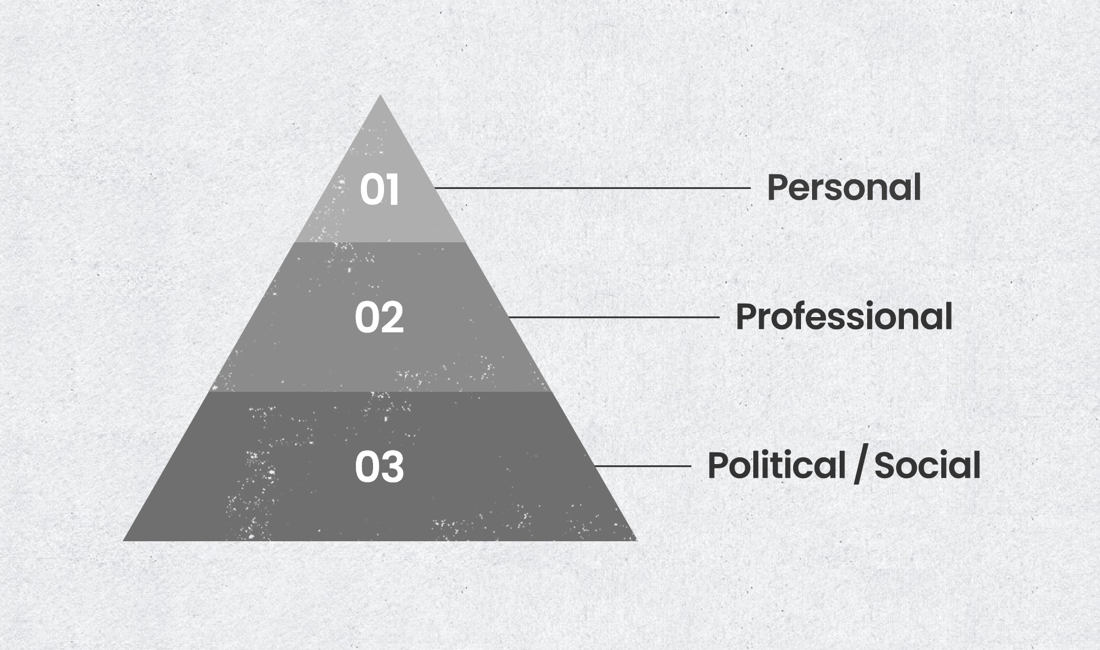

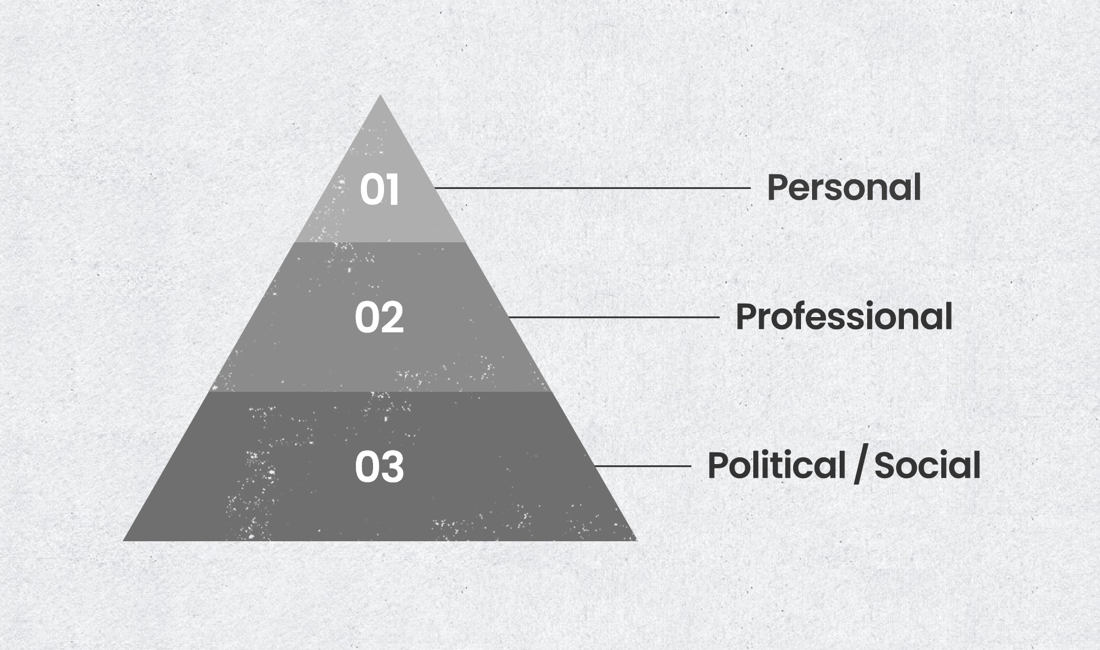

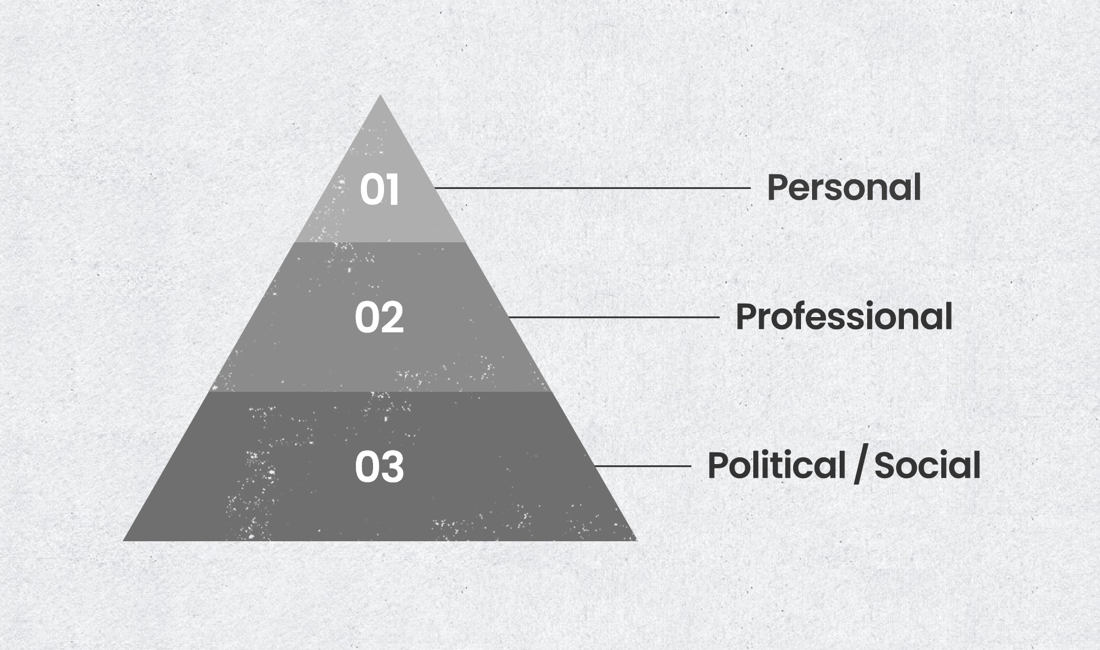

롭 리쉬 매우 좋은 질문이네요. 이건 제가 강의를 시작할 때마다 사람들에게 처음부터 이야기하는 부분이에요. 때때로 철학자가 앞에 나타나면 사람들은 어깨를 으쓱하거나, ‘우리에게 똑바로 살라고 말하는 윤리 전문가 오시네.’라고 생각하곤 합니다. 썩 환영을 받는다고 볼 수 없죠. 저는 사람들에게 윤리학에는 적어도 세 가지 다른 단계의 사고방식이 있다는 걸 상시키기고자 합니다. 첫 번째 단계는 저에겐 가장 덜 흥미로운 단계인 개인 윤리입니다. 물론, 지금보다 더 많은 사람이 윤리적이라면 세상은 더 좋아질 것입니다. 그렇다면 우리는 모든 사람들이 도덕적으로 성자이거나 완벽하게 행동하기를 바라야 할까요? 절대 아니죠. 그건 불가능한 일이니까요. 인간은 불완전해요. 그 누구도 성인군자가 아니며 성자는 우리는 모두 다양한 결함으로 고통받습니다. 따라서 우리의 목표가 미래의 악행을 예방하기 위한 백신으로써의 윤리학이라면 적절하지 않습니다. 미래에 나쁜 일을 하는 것을 막아 주는 윤리학 주사 같은 것은 없기 때문이죠.

저에게 좀 더 흥미로운 것은 두 번째와 세 번째 단계의 윤리학입니다. 두 번째는 직업 윤리인데요. 직업에서 사람들을 하나로 묶는 직업 규범과 구조는 무엇일까요? 고전적인 예로 히포크라테스 선서를 한 의사들이나 의료계 종사자들이 있겠죠. “해를 끼치지 말라(Do no harm)” 그에 더해서 진료를 위한 일련의 규범이 있고요. 저는 우리가 인공 지능 과학자들을 위해 더욱 광범위하고 전문적인 규범을 개발할 수 있다고 생각합니다. 이는 아주 훌륭한 공헌이 될 것입니다.

그리고 마지막 세 번째 단계는 정치 또는 사회 윤리입니다. 우리의 행동을 형성하는 제도에 대해 어떻게 생각해야 할까요? 어떻게 하면 더 나은 제도를 설계할 수 있을까요? 인간이 무엇을 하든 일반적으로 더 나은 방향으로 나아갈 수 있도록 말입니다. 다시 말씀드리지만, 윤리 전문가가 ‘더 나은 사람이 되는 방법을 알려주기 위해 여기 왔다’고 말하면, 사람들은 항상 얼굴을 찌푸립니다. 우리는 모두 거짓말이나, 사기, 도둑질을 해선 안 된다는 것을 압니다. 우승을 위해 금지 약물을 투약한 ‘투르 드 프랑스’ 우승자인 올림픽 자전거 선수 랜스 암스트롱(Lance Armstrong)처럼 되어서는 안 된다는 것, 기술의 힘으로 소비자를 속인 기업 ‘테라노스(Theranos)’를 설립한 스탠퍼드 중퇴자 ‘엘리자베스 홈즈(Elizabeth Holmes)처럼 되어서는 안 된다는 것을 알죠. 우리는 이런 말을 하기 위해 윤리학 수업이 필요한 것이 아닙니다. “거짓말을 하거나, 사기를 치거나, 물건을 훔치지 마세요.” 이런 것들을 스탠퍼드에 오기 전까지 배우지 않았다면 이미 너무 늦었죠. 우리에게 필요한 것은 제도적 차원에서의 윤리 수업과, 책임감 있는 사람이라면 삶에서 종종 마주할 수 있는 여러 가치 충돌의 상황에 맞서는 것입니다.

윤송이 다음으로 정부의 정책에 대해 또 다른 질문을 드리고 싶습니다. 정부가 혁신을 촉진하면서 동시에 책임감 있는 개발을 보장하기 위해 채택할 수 있는 정책 유형은 무엇일까요?

롭 리쉬 네, 우선 이 부분은 저의 전문 분야가 아니기도 하고 이에 대한 연구를 완벽하게 끝낸 것은 아니기 때문에 이번 답변은 잠정적이라는 점을 먼저 말씀드릴게요. 저는 일반적인 형태와 특수한 형태 두 가지를 말씀드리고 싶어요. 일반적인 이야기를 먼저 하자면, 과학적 발견이나 기술 혁신이 정부가 그에 맞는 규제를 정하거나 개발하는 능력보다 앞서 나가는 일이 흔하다는 것입니다. 핵 에너지나 생명 의학 연구 또는 산업 혁명의 초기 시대에 나타났던 형태죠. 따라서 공공 정책을 수립하는 리더의 지식 수준이 과학 기술의 혁신을 이끄는 대학이나 산업 내의 사람들의 지식 수준과 같지 않다는 점은 특별하게 걱정할 일이 아닙니다. 우리는 그저 전통적인 길을 따르고 있는 것뿐이니까요. 게다가 시대도, 공간도 모두 발전하고 있기 때문에 저는 그 부분에 대해 크게 걱정하지 않습니다.

그럼에도 불구하고, 정부가 특수한 형태로 현명한 규제를 도입하는 경우도 있습니다. 예를 들어, 대만과 영국에서 시도되었던 ‘규제 샌드박스(a regulatory sandbox)’라는 것이 있어요. 기업이 어떤 새로운 접근 방식을 개발한 뒤 정부나 공공 정책 규제 기관에게 먼저 다가가 이렇게 말합니다. “저희가 만든 새로운 ‘이것’을 시장에 출시하고 싶은데, 저희는 이것이 필연적으로 어떤 효과를 불러일으킬지 확신할 수 없습니다. 그러니 일종의 기본적인 규제를 제안합니다.” 그러면 정부는 이렇게 답하죠. “그럼, 우선 당신이 제안한 방식으로 2-3년 동안 시도해 보고, 혁신가로서 시장에서의 초기 지분을 확보한 후, 2-3년 후에 다시 돌아와 그 효과가 무엇이었는지 확인하세요.” 그러고 나면 그 시점에서 공공 정책에 관여하는 사람들이 그 기업이 제안한 규제들이 실제로 어떻게 작용했는지 평가하고, 이후에 조정 과정을 거치는 것입니다. 이건 최종적인 것이 아니라 일시적인 규제 환경을 조성하는 것입니다. 따라서 공공 정책 접근 방식을 통하여 보다 넓은 사회에 정보를 제공할 수 있습니다. 기업이 일단 원하는 대로 하다가 나중에 규제 기관이 들어올 때까지 기다리는 것과는 다르죠. 따라서 저는 이러한 ‘규제 샌드박스’가 다른 나라의 다른 분야에서는 어떻게 사용되고 있는지 자세히 연구하려고 합니다.

윤송이 네, 제가 몸담고 있는 게임 산업과 유사한 것 같아서 매우 흥미롭네요. 게임 산업은 콘텐츠 특성상 정책 입안자에 의해 철저히 심사숙고 되지 못하는 경우가 많기 때문에 자체 규제를 제공하는 업계로 유명합니다. 게임 업계의 기업들은 자율 규제 산업이라는 사실에 자부심을 느끼고 있는데, 이 접근 방식과 정신은 교수님께서 방금 설명하신 것과 비슷하게 느껴져요. 마지막으로 교수님께 드릴 질문이 있습니다. 인공 지능에 대해 낙관적인 태도를 보이셨죠. HAI가 흥미로운 건 인공 지능을 다양한 사회 문제를 해결하는 데 필요한 도구와 기술로 본다는 것 때문이기도 합니다. 포용성, 다양성, 형평성 등등 여러 분야에서요. 인공 지능이 우리 인류가 더 나은 방향으로 나아가는 데 도움을 줄 수 있는 도구라고 특별히 기대하시는 이유는 무엇인가요?

롭 리쉬 네, 이에 대한 대답은 인간과 마찬가지로 인공 지능도 일정한 발달 주기를 통해 성장하는 것으로 비유해 볼 수 있을 것 같네요. 지금은 인공 지능의 10대 시절이라고 볼 수 있어요. 인공 지능은 엄청난 힘을 갖고 있고 마치 통제하기 힘든 10대처럼 더 이상 부모의 말을 듣지 않으면서 새로운 힘을 독립적으로 행사하는 것처럼 보이는 것이죠. 이 비유를 계속 하자면, 그 다음 단계는 성인 초기가 될 것입니다. 성인 초기에 접어들면 대부분의 인공 지능 도구는 차분하게 여러 사람에게 도움되는 방식으로 사회적 관계에도 참여하게 되겠죠. 물론 이것은 인공 지능에 대해 제가 생각하는 비유일 뿐이에요. 하지만 제가 말씀드렸듯이, 테크노 유토피아처럼 AI 과학자들이 완벽한 세상을 가져오거나, 테크노 디스토피아처럼 AI 과학자들이 우리가 소중히 여기는 모든 것을 파괴하는 미래가 오지 않길 바라요. 그 둘 사이 어딘가에 일반적인 수준의 중간 장소가 있을 거예요. 그리고 우리 모두의 역할은 인공 지능 과학이 부정적인 결과만을 숱하게 초래하는 미래가 아니라 인간을 지원하며 생산적인 미래로 이끌어 가도록 하는 것입니다. 저는 우리가 ‘지금 이 순간’에 와 있다고 생각합니다. 그 순간을 명확하게 보고 더 나은 미래를 위해 세대의 일에 참여하는 것이 우리의 과제라고 생각합니다.

윤송이 멋지네요. 시간 내주시고 의견 공유해 주셔서 다시 한 번 감사드립니다.

롭 리쉬 앞으로 언젠가 직접 만나서 이런 이야기를 할 수 있길 바라요. 너무 멋질 것 같지 않나요? 송이 님이 계신 세계의 사람들을 만나서 대화도 나눠 보고 싶습니다. 나중에 어떤 분이든 제가 있는 캠퍼스로 오신다면 환영할 준비가 되어 있어요.

윤송이 감사합니다.

롭 리쉬 저도 감사합니다, 송이 님.

Facebook

Facebook  KakaoTalk

KakaoTalk  LinkedIn

LinkedIn  Email

Email  Copy URL

Copy URL